Katakan apa? Obrolan Dengan RTX Menghadirkan Chatbot Khusus ke PC AI NVIDIA RTX

Chatbots digunakan oleh jutaan orang di seluruh dunia setiap hari, didukung oleh server cloud berbasis GPU NVIDIA. Kini, alat inovatif ini hadir di PC Windows yang didukung oleh NVIDIA RTX untuk AI generatif lokal, cepat, dan terkustomisasi .

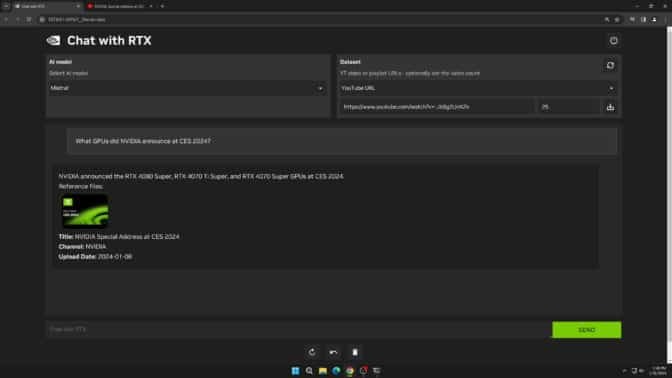

Obrolan dengan RTX , kini dapat diunduh gratis , adalah demo teknologi yang memungkinkan pengguna mempersonalisasi chatbot dengan konten mereka sendiri, yang dipercepat oleh GPU lokal NVIDIA GeForce RTX 30 Series atau lebih tinggi dengan memori akses acak video atau VRAM minimal 8 GB.

Tanyakan apapun padaku

Obrolan dengan RTX menggunakan retrieval-augmented generation (RAG), perangkat lunak NVIDIA TensorRT-LLM , dan akselerasi NVIDIA RTX untuk menghadirkan kemampuan AI generatif ke PC Windows lokal yang didukung GeForce. Pengguna dapat dengan cepat dan mudah menghubungkan file lokal di PC sebagai kumpulan data ke model bahasa sumber terbuka yang besar seperti Mistral atau Llama 2, memungkinkan kueri untuk mendapatkan jawaban yang cepat dan relevan secara kontekstual.

Daripada mencari melalui catatan atau konten yang disimpan, pengguna cukup mengetikkan pertanyaan. Misalnya, seseorang mungkin bertanya, “Restoran apa yang direkomendasikan pasangan saya saat berada di Las Vegas?” dan Obrolan dengan RTX akan memindai file lokal yang ditunjuk pengguna dan memberikan jawaban sesuai konteks.

Alat ini mendukung berbagai format file, termasuk .txt, .pdf, .doc/.docx, dan .xml. Arahkan aplikasi ke folder yang berisi file-file ini, dan alat tersebut akan memuatnya ke perpustakaannya hanya dalam hitungan detik.

Pengguna juga dapat memasukkan informasi dari video dan playlist YouTube. Menambahkan URL video ke Obrolan dengan RTX memungkinkan pengguna mengintegrasikan pengetahuan ini ke dalam chatbot mereka untuk pertanyaan kontekstual. Misalnya, mintalah rekomendasi perjalanan berdasarkan konten dari video influencer favorit, atau dapatkan tutorial singkat dan cara berdasarkan sumber daya pendidikan terbaik.

Karena Obrolan dengan RTX berjalan secara lokal di PC dan stasiun kerja Windows RTX, hasil yang diberikan cepat — dan data pengguna tetap ada di perangkat. Daripada mengandalkan layanan LLM berbasis cloud, Chat dengan RTX memungkinkan pengguna memproses data sensitif di PC lokal tanpa perlu membaginya dengan pihak ketiga atau memiliki koneksi internet.

Selain GPU GeForce RTX 30 Series atau lebih tinggi dengan VRAM minimal 8 GB, Chat dengan RTX memerlukan Windows 10 atau 11, dan driver GPU NVIDIA terbaru.

Catatan Editor: Kami telah mengidentifikasi masalah dalam Obrolan dengan RTX yang menyebabkan penginstalan gagal saat pengguna memilih direktori penginstalan berbeda. Ini akan diperbaiki pada rilis mendatang. Untuk saat ini, pengguna harus menggunakan direktori instalasi default (“C:\Users\\AppData\Local\NVIDIA\ChatWithRTX”).

Mengembangkan Aplikasi Berbasis LLM Dengan RTX

Obrolan dengan RTX menunjukkan potensi mempercepat LLM dengan GPU RTX. Aplikasi ini dibuat dari proyek referensi pengembang TensorRT-LLM RAG, tersedia di GitHub . Pengembang dapat menggunakan proyek referensi untuk mengembangkan dan menerapkan aplikasi berbasis RAG mereka sendiri untuk RTX, yang dipercepat oleh TensorRT-LLM. Pelajari lebih lanjut tentang membangun aplikasi berbasis LLM .

Ikuti aplikasi Windows yang didukung AI generatif atau plug-in ke kontes pengembang NVIDIA Generative AI pada NVIDIA RTX , yang berlangsung hingga Jumat, 23 Februari, untuk berpeluang memenangkan hadiah seperti GPU GeForce RTX 4090, GPU lengkap, in- tiket konferensi orang ke NVIDIA GTC dan banyak lagi.

Pelajari lebih lanjut tentang Ngobrol dengan RTX .